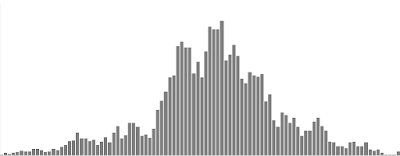

SET ที่เดิม บีบตัวไม่มี Volume สัดส่วนหุ้นขึ้น-ลงแทบไม่เปลี่ยนแปลง ไม่มีสัญญาณใหม่ ขึ้นกับลงพอๆกัน ส่วนตัวไม่ได้มองว่าจะมีลงแบบตูมเดียว 100 จุด ไม่เหมือนบรรยากาศของจุดสูงสุด ทรงแบบนี้ตลาดน่าจะอมหุ้น indicator เกือบทุกตัวในตลาดเหวี่ยงอยู่ที่ cut point พอดี และมีสัดส่วนหุ้นที่บวกในเดือนนี้ ~40% แทบไม่มี Overbought (~1%) รวมทั้ง PE ตลาดด้วย(สูงเหมือนเดิม) คือมันสมดุล แสดงว่าทุกคนในตลาดก็ควรจะ exposure >50% ไปจนถึงเต็ม port น่าจะราวๆนี้

ในขณะที่ธุรกิจดีขึ้น ที่บ้านก็ดี คนมาขอใบรับรองแพทย์สมัครงานเยอะกว่าช่วงก่อน ที่ไม่เข้าท่าอย่างเดียวคือ การขึ้นค่าแรงขั้นต่ำ อาจจะทำให้ค่าครองชีพสูงขึ้นไปอีก คือการขึ้นแค่ 5-10 บาทต่อคนมันอาจไม่มีนัยยะเลยนะ ซึ้อน้ำเปล่าได้เพิ่มขึ้น 1 ขวดต่อวันที่ไปทำงาน รายจ่ายที่มาตกที่บริษัท 5-10 บาท มีพนักงานแค่ 100 คนคงไม่เท่าไหร่ แต่มอง scale ใหญ่ขึ้น "บริษัทขาดความสามารถในการแข่งขัน" มันสำคัญมากเลยนะ เพราะประเทศเราไม่ได้ขับเคลื่อนด้วยแรงงานขั้นต่ำ แต่"จำเป็นต้องมี"คือมันหลีกเลี่ยงได้ยาก ถ้าบริษัทเราไม่ใหญ่จริง แต่เรื่องการขึ้นค่าแรงเป็นเรื่องซับซ้อน ผมเองก็ไม่ได้เข้าใจกลไกจริงๆของมัน ไม่ขึ้นก็ไม่ได้ เพราะจริงๆเราก็ควรจะมีรายจ่ายราวๆ 10,000 บาทต่อเดือนยืนพื้น (ค่าเฉลี่ยของประเทศคือ 20000-25000 บาท/เดือน) ปัญหามันไม่ได้ก่อความลำบากให้กับพวกเรามากนัก แต่มันกระทบต่อการแข่งขันของบริษัทครับ มันเป็นแบบนี้ครับ...

อ้างอิงจากสถิติเก่า

ถ้าบริษัทไหนใช้เครื่องจักร+แรงงาน"ฝีมือ" เป็นสัดส่วนสูงกว่า แรงงานขั้นต่ำ มันจะสร้างช่องว่างของ 2 บริษัทให้ห่างขึ้นไปอีก การแข่งขันที่สูงอยู่เดิม+ความยากในการแข่งขัน ถ้าบริษัทไหนหาทางออก โดดไปใช้แรงงานฝีมือได้(แล้วประเทศเรามีแรงงานฝีมือเยอะ?) โดดไปใช้เครื่องจักร(แล้วเรามีทุนขนาดโดดไปใช้ได้เลยหรือไม่?) มันเหมือนเสริมให้เสี่ยทุนใหญ่ยืนได้ง่ายขึ้น พวกขนาดเล็กและกลางก็ไปดิ้นรนกันเอง SME ก็ไปสู้กันท่ามกลางการแข่งขันสูงลิบๆ พวกเรามัน GenY อายุ 20-40 ก็อยากมี Small enterprise เป็นของตัวเอง แต่แรงงานขั้นต่ำในอนาคต มันอาจจะเป็นกำแพงกั้นระหว่างเรากับ Large enterprise ก็ได้ ใครจะไปรู้ ตัวเลขความล้มเหลวของการ"เริ่มต้นธุรกิจ"จะมีสัดส่วนสูงขึ้นแบบอัตตราเร่ง ซึ่งก็ตรงกับสถิติ และสัจจะธรรมของโลกทุนนิยม

===> เราควรจะแก้สัดส่วน "แรงงานฝีมือ" ให้มีปริมาณมากก่อน เหมือนที่เราชอบพูดกัน "คนไทยไม่แพ้ชาติใดในโลก" ถ้าแรงจูงใจในการเติบโตจาก แรงงานขั้นต่ำ ไปเป็น แรงงานฝีมือ ไปเป็นเจ้าของกิจการ มีมากพอ มันก็น่าจะเป็นรางวัลให้กับคนที่ก้าวไปข้างหน้า ดีกว่าเพิ่มต้นทุนให้ฐาน แต่ขาดอำนาจในการแข่งขัน มันจะคุ้มต่อภาพรวมจริงๆหรอ? ความเหลื่อมล้ำของรายได้จะไม่โดดไปไกลกว่านี้หรอ?

Port YTD 18.24%

SET YTD 16.59%

แผนเดิม control Heat ให้พอๆกับ SET ก็พอ DD ปิดสิ้นปีน่าจะไม่เกิน 15% และจะปิดปีได้ YTD เป็นบวก

เรื่อง control heat นี้คือดูค่าเฉลี่ย Volatile Port ให้ไม่สูงเกินไป แทนการคุม exposure (แต่ exposure เต็มอยู่ตอนนี้เพราะ Heat ไม่ได้สูงอย่างที่คิด) คิดว่าช่วงนี้ต้องไม่หวัง profit มาก heat เกินก็ลดไปก่อน เป้าของ Exposure คือ 50% เหมือนเดิม พร้อมทิ้งทุกเมื่อ ถ้า SET ยังไม่มี FTD ยังไม่เล่น Long Trend คิดไม่ออกว่าถ้าตลาดไม่ใช่ uptrend จะมีตัว HomeRun ได้เยอะขนาดไหนถ้าไม่โชคดีจริงๆ แต่ยอมรับว่าวิธีนี้ทำให้รอบนี้ Port มี profit จาก DD ล่าสุดแค่ 5% เท่านั้นเอง ก็กำลังศึกษาโมเดลที่ใช้การควบคุมอัตตราเฉลี่ยการเคลื่อนที่ของราคาหุ้นใน port เพื่อ scale in/out (ไม่ใช่การ buy/sell) แนวคิดนี้ดูดี ในตลาดที่ Volatile สูง ก็ควรลด Volatile ใน port สวนทางกับตลาดโดยรวม [ไม่ใช่การ rebalance correlation อันนั้นจะดูทิศทาง(Direction) แต่อันนี้จะดูความผันผวน] ยังไม่รู้ว่าสรุปแล้วดีไหม เพราะยังไม่เห็นผลชัดๆ มีข้อดีย่อมมีข้อเสีย

สรุปแผนคือ Control Heat ไม่ให้ volatile สูงเกินกว่า 4% + ถ้ามี DD ขายออกก่อน 30% + Trailing stop ใกล้กว่าเดิม (run trend ยาว ถ้า stop ไม่ลึก) + พร้อม Panic ทิ้ง 50%ตามเป้า exposure

Momentum 4/12/2016