Price Distribution (Part 2 : Test Of Distribution)

จากความเดิมตอนก่อน เราพอจะทราบคร่าวๆว่า Daily Price Change นั้นไม่ได้กระจายตัวแบบ Normal Distribution (http://idestinyo.blogspot.com/2016/10/price-distribution-part-1-normal.html) ซึ่งสำคัญมากในการแปลผลค่าทางสถิติ โดยเฉพาะอย่างยิ่ง ความน่าจะเป็น ใน Part นี้พิสูจน์ให้เห็นภาพชัดยิ่งขึ้น นอกจากเราจะรู้ว่าการกระจายตัวของผลตอบแทนรายวันของ SET ไม่ใช่ การแจกแจงแบบปกติแล้ว เราจะรู้ขนาดความคลาดเคลื่อนด้วยว่าหากเรายังแปลผลแบบเดิม เรามีโอกาสผิดพลาดได้มากขนาดไหน ด้วยขนาดความเชื่อมั่น เราก็จะใช้สถิติเชิงอนุมาน ชนิด Non-parameter เพราะเรากำลังอนุมานข้อมูลอนุกรมเวลาดังที่กล่าวไปแล้ว

เหมือนเดิมครับ ผมจะเล่าปัญหาก่อน ส่วนถัดไปผมก็จะพิสูจน์ และคงความเป็นคณิตศาสตร์ไว้บางส่วน แล้วเดี๋ยวจะอธิบายไว้ที่หลังนะครับ

การทดสอบข้อมูลใดๆ ว่าเป็นการแจกแจงแบบ Normal Distribution รึเปล่าเราเรียกวิธีการนี้ว่า Normality test

Normality Test นั้นมีหลายวิธีมากซึ่งก็มาจากการพิสูจน์สมมติฐานในวิชาสถิติ สามารถหาอ่านได้ในหนังสือสถิติทั่วๆไป เช่น

1) Anderson–Darling test

2) Cramér–von Mises criterion

3) Kolmogorov–Smirnov test

4) Shapiro–Wilk test

5) Pearson's Chi-squared test

และอีกมากมาย วิธีที่ง่ายที่สุดคือ Chi-squared test ไคสแควร์คำนี้น่าคุ้นหูที่สุดแล้วด้วย ตอนสมัยนิสิตแพทย์ผมเรียนปี 3 วิจัยในทางการแพทย์ก็เรียนเรื่องนี้ไปสอบ หลักการก็คือการเทียบข้อมูลของเรากับค่ามาตราฐานที่สร้างบนความน่าจะเป็น ณ ตำแหน่งข้อมูลเดียวกัน แต่ข้อเสียมันก็คือถ้าใช้กับข้อมูลที่มีปริมาณมาก (ใน case ของเราคือ ~10000) Degree of Freedom ก็จะเยอะเกินกว่าจะมีในตาราง Chi-Squared มาตราฐาน จริงๆก็แก้ไข้ได้ด้วยการปรับข้อมูลเป็นอันตราภาคชั้นก็ได้ พิสูจน์ได้เหมือนกัน แต่ความน่าเชื่อถือก็จะน้อยกว่าวิธีอื่น (Beta power ไม่เยอะเท่าวิธีอื่น) ส่วนวิธีที่มีความน่าเชื่อถือที่สุดในการทดสอบ Normality ก็คือ Shapiro–Wilk test (พิสูจน์ Beta power จาก MonteCarlo ในข้อมูลสุ่ม) แต่เราก็จะเจอปัญหาเดียวกันกับ Chi-Squared test เรื่องของปริมาณข้อมูล

ในที่นี้ผมจึงใช้วิธี Kolmogorov–Smirnov test ชนิด one-tailed test เนื่องจากเข้าใจง่ายที่สุดแล้วครับ แล้วก็วิธีทำก็ไม่ยากด้วย

(แต่ก็ไม่ต้องสนใจวิธีทำก็ได้ครับ เดียวผมจะอธิบายด้วยรูปอีกที)

Null Hypothesis ของเรายังเหมือนเดิม คือ สมมติฐานว่าการแจกแจงข้อมูลรายวันของ SET Index เป็นการแจกแจงแบบปกติที่ ค่าเฉลี่ยที่ 0.026 และ ส่วนเบี่ยงเบนมาตราฐานที่ 1.436

ให้ S(x) แทน Cumulative Distribution Function ของข้อมูลที่เก็บได้ (ซึ่งเรายังไม่รู้ว่ามีการแจกแจงแบบใด)

วิธีพิสูจน์คือ สมมติ G(x) แทน Cumulative Distribution Function ของ Normal Distribution ซึ่งคือค่าทางทฤษฎีที่ควรจะเป็น

แทนค่า H0 (Null Hypothesis) : S(x) = G(x) { x̄ = 0.026 , SD = 1.436 }

และ H1 : S(x) ≠ G(x)

กำหนดระดับนัยสำคัญ alpha ที่ 0.05 ( α = 0.05)

ตัวทดสอบสถิติ Kolmogorov Smirnov statistic คือ Dn = supx lS(x) - G(x)l

(สูตรนี้ในภาษาคนอธิบายคือ Sup = Supremum คือ ค่าขอบเขตบนสูงสุดในเซตของ Function ดังกล่าว ในที่นี้คือค่าสมบูรณ์ของความแตกต่าง CDF ของ S(x) และ G(x))

Critical values for the Kolmogorov-Smirnov Test for goodness of fit =

เมื่อ n = จำนวนข้อมูลทั้งหมด

α = ระดับนัยยะสำคัญ ในที่นี้เรากำหนด 0.05

ปล. ที่ใช้สูตรนี้เพราะเป็นการ test แบบ one-tailed test จริงๆจะไปเปิดตาราง Kolmogorov Smirnov Table ก็ได้ แต่สูตรนี้คือสูตรในรูปทั่วไป

ปล2. ln คือ log ฐานธรรมชาติ

ยอมรับ H0 เมื่อ Dn < Critical values at α 0.05

หมดส่วนนิยามแล้วครับ มึนตึบไปเลยไหมครับ จริงๆส่วนนิยามระเบียบทางคณิตศาสตร์ นั้นไม่ได้ยากครับ ที่ทำยากคือการเตรียมข้อมูลใน Function เรามาเริ่มจากแนวคิดพื้นฐานกันก่อนครับ ถ้าเข้าใจจุดเริ่มต้นของทฤษฎีแล้ว ที่เหลือมันจะดูง่ายไปหมด เหมือนที่เค้าพูดกันว่า คณิตศาสตร์นั้นถ้าเข้าใจแล้ว ก็ไม่ต้องท่องสูตรหรอก ลองค่อยๆคิดตามดูช้าๆนะครับ รับรองว่าไม่ยากครับ

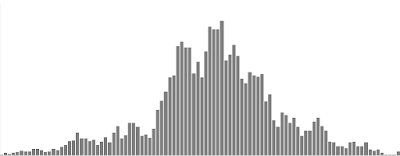

สมมติผมเก็บข้อมูลมาชุดหนึ่ง มีการแจกแจงแบบนี้ตาม Histogram ดังรูป

แบบดังรูปนี้ ดูว่ามันทับสนิดกันดีหรือไม่ ในทางคณิตศาสตร์วิธีแบบนี้เราใช้คำว่า "การทดสอบภาวะสารูปสนิทดี" หรือ Goodness of fit

ลองคิดตามต่อไปเรื่อยๆนะครับ แสดงว่าข้อมูลแต่ละ อันตราภาคชั้น (ในรูปก็คือ 1 แท่งของ Histogram) นั้น ถ้าเป็นการแจกแจงแบบปกติมันควรอยู่ตรงกันกับ แท่ง Histogram ในอุดมคติ (ในรูปก็คือเส้นสีน้ำเงิน)

ในความเป็นจริง เราก็ต้องพยายามปรับ Parameter ให้ใกล้เคียงกับข้อมูลของเรามากที่สุด เมื่อได้ค่าทางทฤษฎีแล้ว มันก็จะมีบาง Histogram ที่ตรงกันกับค่าทางทฤษฎี บาง Histogram ก็จะไม่ตรงกับค่าทางทฤษฎี เราจะต้องเข้าใจก่อนว่า "=" ในทางสถิติ ไม่ได้หมายความว่า "เท่ากับ" เปะๆแบบสมการคณิตศาสตร์ทั่วๆไป แต่มันมีหมายความว่า "ใช้แทนกันได้" คำพูดที่บอกว่า "ใช้แทนกันได้" ก็คือการอนุมาน ว่าอ๋อ...ถ้าข้อมูล A ใกล้เคียงกับข้อมูล B มาก เราก็สามารถใช้ข้อมูล B แทนได้เลย ค่าที่ได้อนุมานว่า "เหมือนกัน"

แต่เพราะมันไม่ใช้เท่ากับจริงๆ เราแค่อนุมานว่าเหมือนกัน เราจึงต้องสร้างขอบเขตยอมรับ ว่าเรายอมให้ข้อมูลผิดพลาดได้ขนาดไหนถึงจะยอมให้ใช้แทนกันได้ เราจะยอมทิ้งข้อมูลไปบางส่วน ในที่นี้คือค่า Alpha หรือ α ถ้าหากทิ้งข้อมูลไปบางส่วนแล้วยังไม่อาจแยกข้อมูลได้ขาดจากกันได้ เราก็จะสรุปว่า "ไม่แตกต่างกันอย่างมีนัยสำคัญทางสถิติที่ α = ค่าที่เรากำหนด" เพราะฉะนั้นจึงอนุมานว่า "ใช้แทนกันได้ที่ความมั่นใจ 1-α"

การกำหนดค่า alpha ที่ 0.05 หรือ 5% ก็เป็นค่ามาตราฐานที่เราใช้กัน เราก็จะมีความมั่นใจ 95%

ทั้งหมดคือหลักการพื้นฐานครับ ทีนี้เราได้เข้าใจที่มาที่ไปแล้ว ส่วน Model ทางคณิตสาสตร์เพื่อทดสอบสมมติฐานคงจะอธิบายทั้งหมดไม่ไหว ขนาดสมัยเรียนยังต้องเรียนเป็นเดือนเลยครับ ให้ลองหาอ่านเพิ่มเตินในเรื่อง สถิติอนุมาน (Inferential Statistics) มีคำถาม ถามได้นะครับ ผิดถูกยังไงจะได้ช่วยกันแก้

เข้าเรื่องกัน หลักการของ Kolmogorov–Smirnov test (Ref: https://en.wikipedia.org/wiki/Kolmogorov%E2%80%93Smirnov_test)

ก็ใช้หลักการข้างตั้นทั้งหมดที่ได้อธิบายมา โดยหัวใจสำคัญอยู่ที่เราจะเปรียบเทียบ CDF (Cumulative Distribution Function) นั่นเอง ลองอ่านเพิ่มสั้นๆจาก link ก็ได้ครับ

--> นำข้อมูลมาเรียงจากน้อยไปมาก column B

--> สร้าง CDF จากข้อมูลของเรา (ความน่าจะเป็นสะสม) column D แทนด้วย Function S(x)

--> สร้าง Expected Z value column E ขั้นตอนนี้คือการสร้างข้อมูลตามทฤษฎี สำคัญมาก ถ้าเราเชื่อว่าข้อมูลเป็นการแจกแจงปกติจริง จะต้องประมาณความน่าจะเป็นได้จากสูตรมาตราฐาน โดยนำ SD กับ x̄ มาใช้คำนวนข้อมูลมาตราฐานจากความน่าจะเป็นสะสมที่สร้างใน column D โดยนำสูตร PDF ใน Part ที่ 1 มา intregrate จะได้ CDF ดังนี้

โดยที่ p = ความน่าจะเป็น CDF ของข้อมูล x บนการแจกแจงปกติที่ x̄ = μ และ SD = σ

หรือก็คือการถอดสมการหาค่า x ในสูตรนั่นเอง

ชื่อ Normal inverse cumulative distribution function ไม่ต้องตะลึงกับสูตรครับ ใน excel ก็มี Function ให้เราใช้แทนค่าไม่ถึง 10 วินาทีก็ได้แล้ว หรือจะใช้ Matlab ก็ได้ ในกรณีที่ข้อมูลเราเยอะเกินกว่าที่ excel จะคำนวนได้ (Excel limit Row ที่ 1,048,576 มันจะไม่มีปัญหาถ้าใช้ข้อมูลหุ้นตัวเดียวเช่น SET ก็แค่ 10,000 ข้อมูล แต่มันมีปัญหามากตอนที่วิจัยโดยใช้ข้อมูลหุ้นทุกตัวเอาแค่ในประเทศไทยเก็บ daily price change ทั้งหมดจะได้ 4 ล้านตัว excel จะไม่สามรถทำได้แล้วครับ ต้องใช้ R ไม่ก็ Matlab ช่วย แต่ก็ต้องมี CPU กับ Ram ที่รองรับข้อมูลมหาศาลขนาดนี้ ยอมรับว่าผมไม่มีคอมใช้วิจัยที่ดีกว่า macbook air แล้วครับ ลำพังแค่เรียกดูข้อมูลก็ค้างแล้วครับ ผมต้องสุ่มข้อมูลโดยใช้ Monte carlo แทนการใช้ข้อมูลทั้งหมดใน part ต่อๆไป ซึ่งก็คงสู้การใช้ข้อมูลดิบทั้งหมดไม่ได้ แต่ก็พออนุมานได้เป็นวิทยาทาน ถ้าผมมี computer ดีๆ ผมก็อยากหาความจริงของ Price distribution ในเมืองไทยเหมือนกันครับ )

--> สุดท้ายกราฟในอุดมคติที่เราเกริ่นตั้งแต่ต้น column E คือ สร้าง CDF ของการแจกแจงปกติมาตราฐาน มีคำว่า"มาตราฐาน"ด้วยนะครับ มันคือ "การแจกแจงปกติ ที่ x̄ = 0 , SD = 1" คือกราฟที่รู้จักกันทั่วโลก ที่เราชอบอนุมานว่า +-1SD จะมีควมน่าจะเป็น 68% ที่ข้อมูลจะตกอยู่ในช่วงนี้ ตัวเลขความน่าจะเป็น 68% มันก็มาจากพื้นที่ใต้กราฟของการแจกแจงปกติมาตราฐานนั่นเอง พูดได้ว่าถ้าอยากใช้ตัวเลขนี้อ้างความน่าจะเป็น ก็ต้องพิสูจน์ให้ได้ก่อนว่าข้อมูลเราอนุมานได้จากการแจกแจงปกติ ที่เรากำลังทำกันอยู่นี้นั่นแหละครับ และคำนวนพื้นที่ใต้กราฟเพื่อมาซ้อนทับเปรียบเทียบข้อมูลของเรานั่นเอง แทนด้วย Function G(x)

--> คำนวนตัวทดสอบสถิติใน column H ก็ไม่มีอะไรครับ เอา Function มาลบกันเฉยๆ แล้วก็ตัดเครื่องหมายทิ้ง (ใส่ Absolute)

--> หาค่า supremum ของ column H ได้ตัวทดสอบสถิติที่เราต้องการเท่ากับ Dn = 0.091845836 (K-S test)

--> เปิดตารางหาค่าวิกฤต Critical values for the Kolmogorov-Smirnov Test for goodness of fit หรือแทนสูตร Critical values ที่แสดงไว้ในนิยามได้ เท่ากับ 0.013463057

--> เนื่องจาก Dn > Critical values at α 0.05 เราจึงปฎิเสธ H0 (Null Hypothesis) ที่ α = 0.05

--> หรือก็คือ การแจกแจงของ Daily price Change ของ SET index แตกต่างจาก การแจงแจกปกติอย่างมีนัยสำคัญที่ α = 0.05

-->หรือ การแจกแจงของ Daily price Change ของ SET index ไม่สามารถอนุมานได้ด้วยการแจกแจงแบบปกติ ที่ความมั่นใจ 95%

เราก็สรุปได้แล้วว่าการแจกแจงของการเปลี่ยนแปลง SET Index รายวันไม่ใช่ การแจกแจงปกติ เราจึงไม่สามารถนำค่า SD มาประมาณความน่าจะเป็นจากความรู้พื้นฐานของ Normal Distribution ได้

ถ้าเราจะประยุกต์ต่อยอดกับข้อมูลอื่นๆดู ถ้าเราลองนำไปใช้กับ PE นำไปใช้กับ Moving average นำไปใช้กับ Indicator อื่นๆ และลองหา Distribution หุ้นรายตัว แม้กระทั่งลองนำมาใช้กับ portfolio ของเราดู เราจะค้นพบความลับบางอย่างของตลาดหุ้น ว่าจริงๆแล้วที่เราแปลผลกันอยู่ในปัจจุบันนั้น มันน่าเชื่อถือจริงๆรึเปล่า ...ลองถอยกลับมาตั้งคำถามว่า "ผลลัพธ์ของข้อมูลเรานั้น เชื่อถือได้จริงๆรึเปล่า?" ถ้า optimize ค่าที่ดีที่สุดของระบบออกมาแล้ว จริงรึเปล่า? ว่าเราสามารถอนุมานได้ว่าสิ่งที่เราค้นพบคือ parameter ที่ดีที่สุดของประชากรในอนุกรมเวลา ของตลาดหลักทรัพย์ นั่นคือคำถามที่ Quantitative ต้องการคำตอบมากที่สุด

ผมจะแสดงตัวอย่างให้ดูว่าทำไมถึงอนุมานความน่าจะเป็นไม่ได้จากการแจกแจงปกติ เราลองนำข้อมูลมา plot กราฟดูก่อน ผมตัดค่าสูงสุดกับ ต่ำสุดของข้อมูล แค่ 2 ตัวทิ้งเพื่อรูปกราฟที่สวยงาม

แกน X คือ Standard derivation หรือ SD

แกน Y คือ ค่าของข้อมูล

เรียงข้อมูลก่อน แล้วก็เข้าคู่กับ SD ที่อยู่บน แกน X

เส้นสีแดง คือ ข้อมูลของเราครับ

เส้นสีน้ำเงิน คือ ข้อมูลในอุดมคติ ที่สร้างจาก normal distribution นั่นเอง

วิธีแปลผลกราฟนี้คือ ถ้าข้อมูลของเราเป็นการแจกแจงปกติจริง มันจะต้องวิ่งไปล้อกันไปกับเส้นสีน้ำเงิน ที่เป็นการแจกแจงปกติ

อย่างแรก มันก็สอดคล้องกันกับการพิสูจน์ Normality test ข้างต้น เราจะสังเกตว่า ข้อมูลไปกระจุกตรงกลางเยอะ แสดงถึงความโด่งของข้อมูล และตั้งแต่ ~2SD เป็นต้นไป ข้อมูลกระจายตัวไปยังค่าสุดโต่งอย่างมาก ความน่ากลัวมันอยู่ตรงที่ ขนาด 3SD ของกราฟมาตราฐาน ซึ่งข้อมูลจะต้องมีโอกาสเกิดขึ้นน้อยมากๆ (ตามทฤษฎีคือ 1% แบ่งไปทางบวก 0.5% และทางลบ 0.5%) พูดง่ายๆใน 10 ปี(2000วัน) มันควรจะเกิดแค่ครั้งเดียว แต่ในความเป็นจริงพวกเราที่ลงทุนมานานจะรู้สึกว่า มันคนละเรื่องเลย แค่ปีนี้ก็ไม่รู้กี่ครั้งแล้ว ยิ่งไปกว่านั้น ขนาดการเปลี่ยนแปลงลง กับขนาดการเปลี่ยนแปลงขึ้น ยังคาดการณ์ไม่ได้อีก เพราะค่าสุดโต่ง นั้นเลยค่าสุดโต่งทางทฤษฎีไปมาก เราจะเรียกส่วนหาง(tail) ทั้ง 2 ข้าง ว่าเป็น Fat Tail

ผมอยากเตือนเพื่อนๆแบบนี้ครับ "โอกาสที่หุ้นจะเปลี่ยนแปลงไปเกินกว่าทฤษฎีทั่วไป ทั้งในด้านขนาดการเปลี่ยนแปลง และในด้านของความน่าจะเป็นยังพบบ่อยกว่าทฤษฎีอีกด้วย" ผมไม่อยากให้นิ่งนอนใจเกินไป ในเวลา Panic จริงๆ ต้องมีแผนเสมอ

อาจจะมีคนเถียงว่าก็แค่ตัดช่วงข้อมูลที่เกิน +-2SD ไปก็ประมาณได้ว่าเป็น Normal distribution แล้ว แต่ถ้าเป็นเช่นนั้นจะมีประโยชน์อะไรถ้าหากว่าเกิดเหตการณ์ที่เกินกว่า +-2SD (ซึ่งเกิดบ่อย และรุนแรง) แล้วอธิบายตามสถิติเดิมไม่ได้ แถมวันรุ่งขึ้นถ้าต้องการหาความน่าจะเป็นที่หุ้นจะดีดกลับต้องเก็บข้อมูลใหม่ เพราะเป็นเหตุการณ์ที่เงื่อนไขว่าต้องเป็นวันถัดไปและเคลื่อนที่ทิศทางตรงกันข้าม ไว้ใน part หน้าเราจะมาดู distribution ในคาบเวลาต่างๆกัน

"ถ้าเป็นเช่นนั้น หากว่า Model ของ Normal Distribution ใช้ไม่ได้แล้ว เราจะทำอย่างไรกันต่อ?" แน่นอนครับมีคนตั้งคำถามนี้มาก่อนแล้วหลายสิบปี ก่อนตลาดหุ้นไทยจะมีซะอีก จึงมีการคิดค้น Model ของ Distribution ใหม่ๆเพื่อมาอธิบายการเคลื่อนไหวของตลาดหลักทรัพย์มากมาย ที่ดังๆก็อย่างเช่น Cauchy distribution ที่จะอธิบายข้อมูลที่เป็น Fat-tailed distribution ซึ่งลืมสถิติที่เคยเรียนมาให้หมดเลยครับ รวมไปถึง Moment ต่างๆ ก็จะคำนวนไม่เหมือน Normal distribution (อันนี้ก็เป็นเหตุผลว่าทำไม Part 1 ผมถึงเรียกค่า SD,Skewness,kurtosis ว่า Moment เพราะ พอไม่ใช่ Normal distribution แล้ว เราก็ค่อยได้ใช้ Parameter นั้นกันแล้วครับ ถ้าจะศึกษาเรื่องนี้ก็ต้องข้ามไปที่ Engineering Statistic ซึ่งต้องมีพื้นฐาน calculus ระดับหนึ่ง แต่ผมคิดว่า Robot Trade ก็เหมือนเครื่องจักรกล ผลการ trade ก็เหมือน ผลลัพธ์ของสมการ คิดแล้วเรื่องนี้ก็มีประโยชน์ไม่น้อยสำหรับ Quantitative analysis นะครับ) --> แล้ว Model อื่น...เค้าคิดกันยังไง?

ต้องตั้งคำถามต่อว่าเรามองเห็นอะไรในกราฟนี้บ้าง?

จริงๆเราก็หา correlation จากกราฟนี้พิสูจน์เรื่อง Normality test ได้ด้วยนะครับ แต่เราจะไม่พูดซ้ำเรื่องเดิมแล้ว ผมอยากให้มองอย่างนี้ครับ แต่ไหนแต่ไรมา เราก็ใช้ Linear Regression มาทำนายตลอด ก็คือ สมการเชิงเส้น ที่เราพูดๆใน part ก่อนๆเนี่ยแหละครับ แทบจะทุกอย่างเราอิงความน่าจะเป็นบนกราฟเส้นตรงนี้เอง แต่ความจริงอย่างที่พิสูจน์มันไม่ใช่แบบนั้น ถ้าคนเรียน calculus ก็จะพอมองออกว่า กราฟสีแดงอันเป็นการเรียงของข้อมูลของเรานั้นหน้าตาของมันก็คล้ายสมการ Polynomial บางแบบนั่นเอง ทำไมถึงพูดว่า"บางแบบ" เพราะ Polynomial Function ในรูปทั่วไปแสดงได้ดังนี้

นี่แค่ตัวอย่างนะครับ แล้วยังมี Function อีกมากมายเท่าดาวบนฟ้าเลยที่หน้าตาคล้ายกับกราฟเส้นแดงๆในรูป ^ ^

หรือ อีกวิธีที่นิยมกันและง่ายกว่านั้น เพราะไม่ต้องไปยุ่งกับ Calculus มากคือวิธี Tranformation Function ก็ได้ แทนที่จะหาสมการใหม่ ก็ใส่ Function ครอบตัวแปร x ก่อน แปลงให้กลายเป็นสมการเส้นตรงอาจจะง่ายกว่าก็ได้? แค่เราต้องลองดูเท่านั้นเองครับ

เนื่องจากมันไม่มีวิธีตรงไปตรงมา มันต้องมโนขึ้นมาในหัวก่อนว่า จะเป็น Function นี้ได้อย่างไร สองวิธีนี้จึงเข้าใกล้ Advance Math มากกว่าสถิติ แต่ก็น่าจะตื่นเต้นไม่แพ้สถิติเลย

แล้วครั้งหน้าผมจะมาตอบคำถามว่าทำไมต้องใช้ log ในการหาอัตราการเปลี่ยนแปลงด้วย ทั้งๆที่ผลมันก็ไม่ได้ต่างอะไรมากเทียบกับใช้ Simple Change มาตราฐาน มันมีเหตุผลทางคณิตศาสตร์ที่ใช้อธิบายด้วยความรู้ใน Part นี้ ซึ่งเราก็จะลงไปขุด Data ให้ลึกอีกขั้นหนึ่ง

ไม่มีความคิดเห็น:

แสดงความคิดเห็น